Data centers de inteligência artificial consomem muita energia porque executam processamento contínuo de alto desempenho, operam 24 horas por dia, exigem resfriamento intensivo e mantêm sistemas redundantes para evitar falhas. O crescimento em escala da IA transforma a eletricidade em um custo estrutural, não pontual.

O que diferencia um data center de IA de um data center tradicional?

Data centers tradicionais foram projetados para hospedar aplicações corporativas, armazenamento de dados e serviços web com cargas relativamente previsíveis. Já os data centers de inteligência artificial operam sob uma lógica diferente: eles precisam sustentar processamento matemático extremo, com picos constantes e cargas altamente intensivas.

A principal diferença está no tipo de hardware utilizado. Enquanto data centers comuns priorizam CPUs convencionais, os centros voltados à IA utilizam GPUs e aceleradores especializados, que consomem mais energia por unidade, mas entregam desempenho massivo. Essa mudança altera completamente o perfil energético da infraestrutura.

Além disso, a IA exige operações simultâneas em larga escala, o que eleva não apenas o consumo direto de eletricidade, mas também a complexidade do sistema como um todo.

Treinamento de modelos: o maior consumidor de energia

O treinamento de modelos de inteligência artificial é uma das etapas mais intensivas em consumo energético. Grandes modelos exigem semanas ou meses de processamento contínuo, executando bilhões ou trilhões de cálculos matemáticos em paralelo.

Esse processo envolve:

- Uso prolongado de GPUs de alto desempenho

- Execução ininterrupta para evitar perda de eficiência

- Repetição constante para ajustes e melhorias

Mesmo quando um modelo já foi treinado, o ciclo não se encerra. Atualizações, reentrenamentos e adaptações a novos dados mantêm o consumo energético elevado ao longo do tempo, tornando o gasto cumulativo.

Inferência em tempo real: consumo contínuo e invisível

A inferência, etapa em que a IA responde a usuários ou sistemas, costuma ser subestimada no debate energético. Diferentemente do treinamento, que ocorre em ciclos definidos, a inferência acontece de forma permanente, respondendo a milhões de solicitações simultâneas.

Cada resposta gerada por um modelo de IA consome energia. Em aplicações populares, como assistentes virtuais, sistemas de recomendação ou automação corporativa, esse consumo se torna constante e previsível, transformando a eletricidade em um custo fixo da operação.

À medida que a IA se integra ao cotidiano, a inferência deixa de ser um evento pontual e passa a ser uma atividade contínua em escala global.

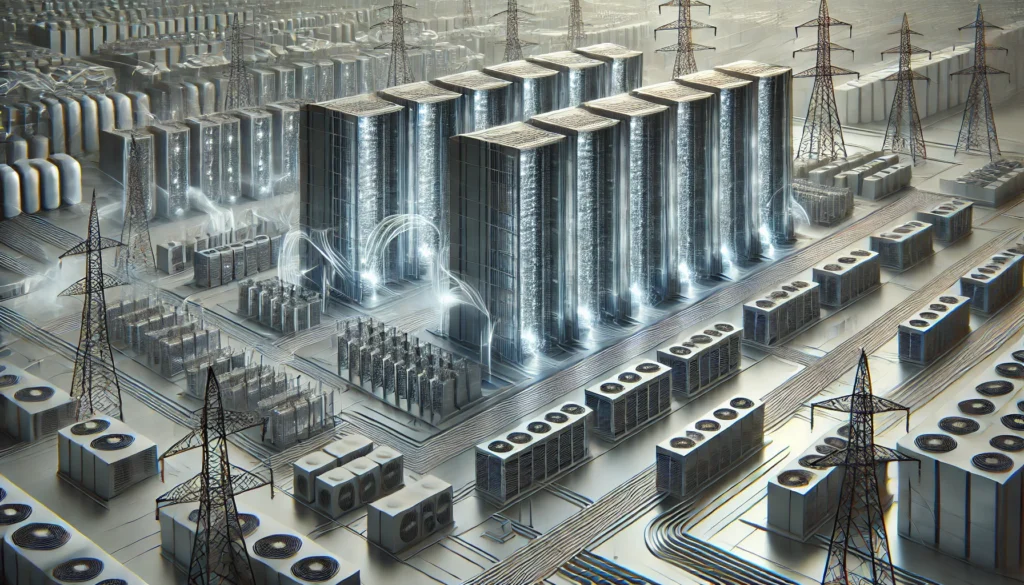

Resfriamento: o custo energético além do processamento

Chips de alto desempenho geram grande quantidade de calor. Para manter a operação estável, os data centers de IA dependem de sistemas avançados de resfriamento, que consomem uma parcela significativa da energia total.

Em muitos casos, o gasto energético com resfriamento pode se aproximar do gasto com processamento. Isso é especialmente relevante em regiões de clima quente ou com infraestrutura térmica menos eficiente.

O desafio não é apenas resfriar, mas fazê-lo de forma contínua, segura e previsível, o que adiciona mais uma camada de consumo energético à operação da IA.

Redundância e confiabilidade: energia sempre ativa

Data centers de inteligência artificial não podem parar. Para garantir disponibilidade contínua, eles mantêm sistemas redundantes, servidores em espera, fontes alternativas de energia e backups ativos.

Mesmo quando não estão sendo utilizados plenamente, esses sistemas consomem eletricidade para permanecerem prontos. Essa redundância é essencial para evitar falhas, mas aumenta o consumo energético estrutural da infraestrutura.

A confiabilidade da IA, portanto, está diretamente ligada a um consumo energético permanente, e não apenas a picos ocasionais.

| Área | Tipo de consumo | Impacto energético |

|---|---|---|

| Treinamento | Processamento intensivo contínuo | Alto consumo prolongado |

| Inferência | Execução constante de respostas | Consumo fixo diário |

| Resfriamento | Climatização térmica | Consumo adicional elevado |

| Redundância | Backups e sistemas duplicados | Consumo constante em espera |

Energia como limite físico da expansão da IA

Mesmo com avanços em eficiência de chips e algoritmos, os data centers de IA enfrentam limites físicos claros. A disponibilidade de energia, a capacidade de transmissão e o custo da eletricidade influenciam diretamente onde esses centros podem ser instalados e expandidos.

Esse cenário explica por que regiões com energia barata, estável e previsível atraem investimentos em infraestrutura de IA. A eletricidade deixou de ser apenas um insumo e passou a ser um fator estratégico.

O consumo energético dos data centers não é um problema isolado. Ele se conecta diretamente ao debate mais amplo sobre energia e inteligência artificial, infraestrutura global e planejamento de longo prazo.

👉 Para entender como esse consumo impacta mercados, sustentabilidade e liderança tecnológica, leia o pilar:

Energia e Inteligência Artificial: por que a eletricidade virou o principal gargalo

Perguntas Frequentes (FAQ)

Por que data centers de IA consomem mais energia que os tradicionais?

Porque utilizam chips de alto desempenho, operam continuamente e exigem sistemas intensivos de resfriamento e redundância.

O treinamento ou a inferência consomem mais energia?

O treinamento concentra picos intensivos, enquanto a inferência gera consumo contínuo. Em larga escala, ambos têm impacto significativo.

Eficiência dos chips reduz o consumo energético total?

Reduz o consumo por operação, mas não elimina o aumento da demanda quando a IA cresce em escala.

A localização do data center influencia o consumo?

Sim. Clima, custo da energia e infraestrutura local afetam diretamente o consumo e a eficiência.

Eduardo Barros é editor-chefe do TecMaker. Atua na curadoria de conteúdos voltados à inovação tecnológica, cultura maker e inteligência artificial aplicada à educação. Sua análise busca desmistificar tendências e fortalecer práticas educacionais baseadas em critérios técnicos e aplicabilidade prática.